Overview

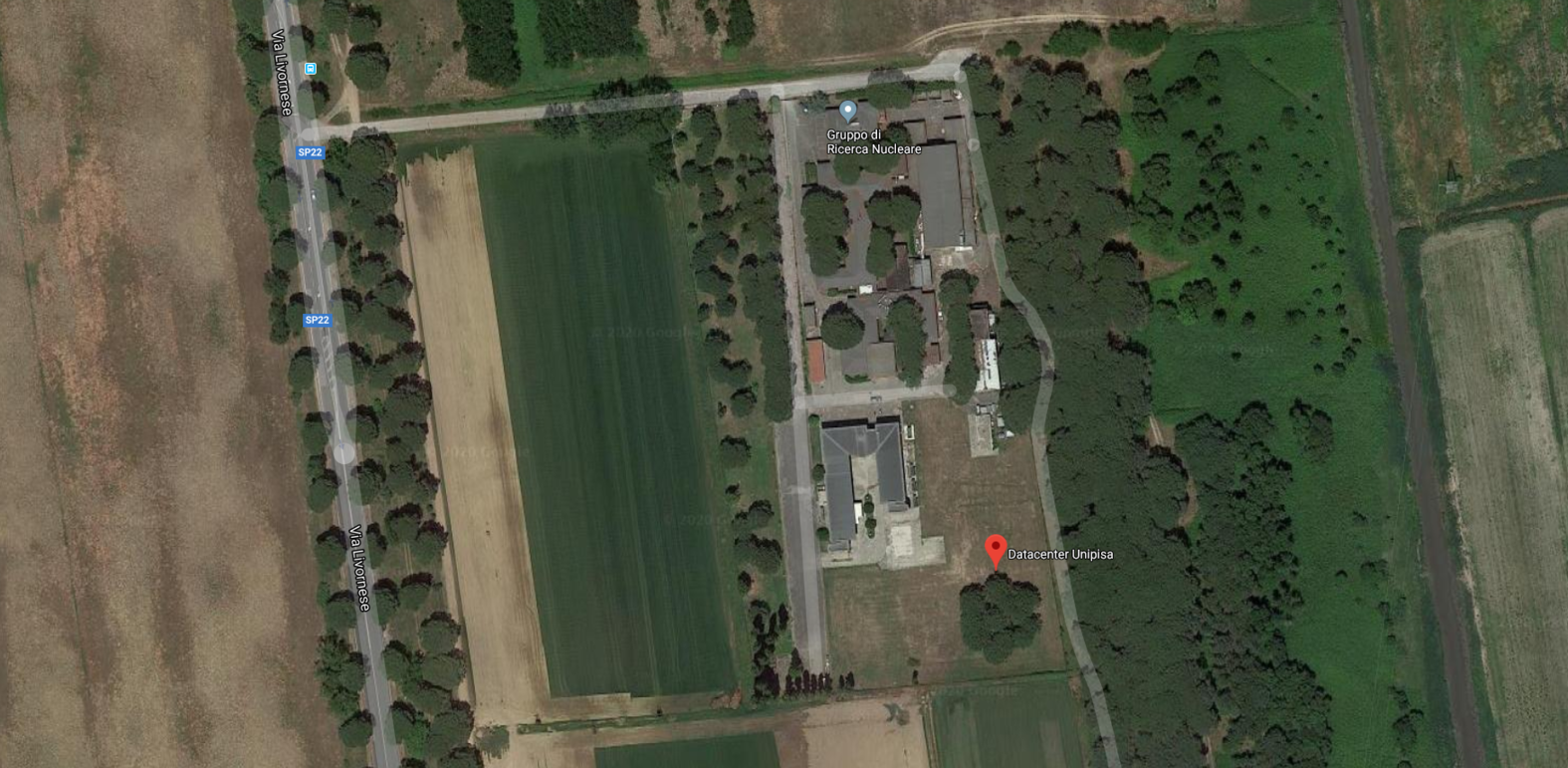

Il Green Data Center dell’Università di Pisa è situato a San Piero a Grado . Si tratta di un Data Center classificato tra i 62 in gruppo A su 1.152 censiti da AgID su tutta la Pubblica Amministrazione nazionale, che fa uso di tutte le più moderne tecnologie per alimentare un grande numero di server riducendo al minimo i costi necessari al raffreddamento.

La denominazione Green deriva dal progetto pensato per avere l’impatto ambientale minore possibile. Nell’arco di 7 anni infatti ha registrato un PUE medio di 1,2 quindi per ogni KW assorbito per il calcolo utile si sono resi necessari solo 200W aggiuntivi per il raffreddamento.

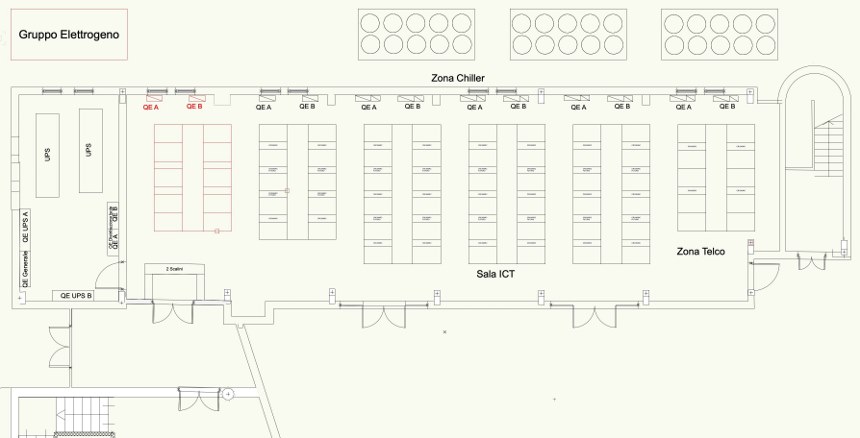

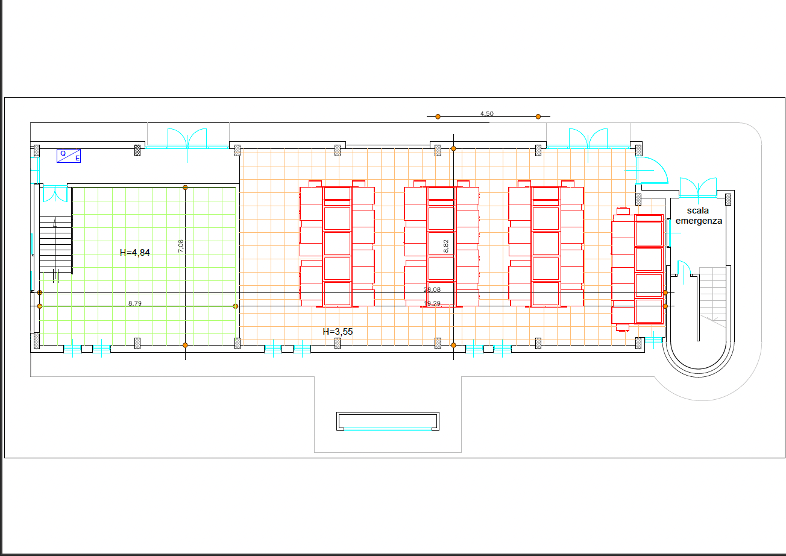

La sala macchine

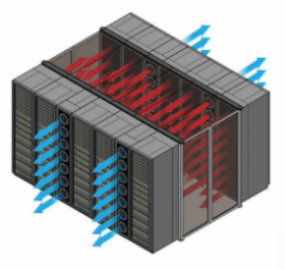

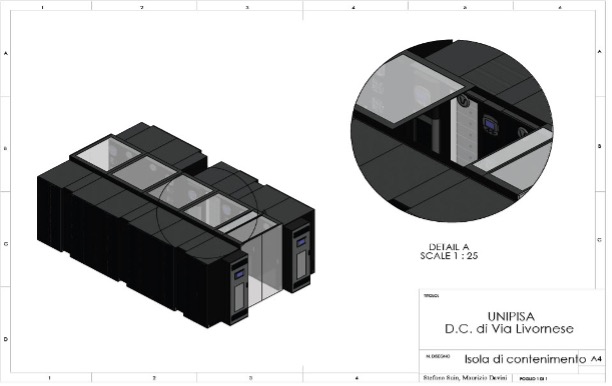

La sala macchine, la cui pianta è illustrata nella figura di seguito a sinistra, è progettata per un efficiente raffreddamento mediante confinamento ad isola calda, come esemplificato nella figura seguente a desta.

Attualmente nel Data Center sono complessivamente a disposizione del calcolo scientifico circa 700 nodi di calcolo per un totale di 25K cores di calcolo , 200TB di RAM e circa 100 GPU di varie generazioni.

I sistemi di calcolo scientifico a disposizione includono :

- servers multiprocessore con elevata quantità di memoria RAM( High Memory Nodes)

- clusters di calcolo HPC medio piccoli ( 16-32 nodi ) con connessione ad alta velocità e bassa latenza ( Infiniband/Omnipath)

- servers mono/multi GPU ( tra cui 4 Nvidia DGX /A100 e H100)

- servers manycores con processore ARM di nuova generazione

Si aggiungono una infrastruttura di virtualizzazione basata su tecnologia VMware ed una basata su tecnologia Microsoft che garantiscono la possibilità di ottenere risorse computazionali in modo semplice e veloce ( in parte con modalità self-service).

I sistemi di calcolo sono collegati ad una infrastruttura di storage di ultima generazione composta da storage AllFlash attraverso una rete di interconnessione ad alta velocità ( 25-400 Gb/s).

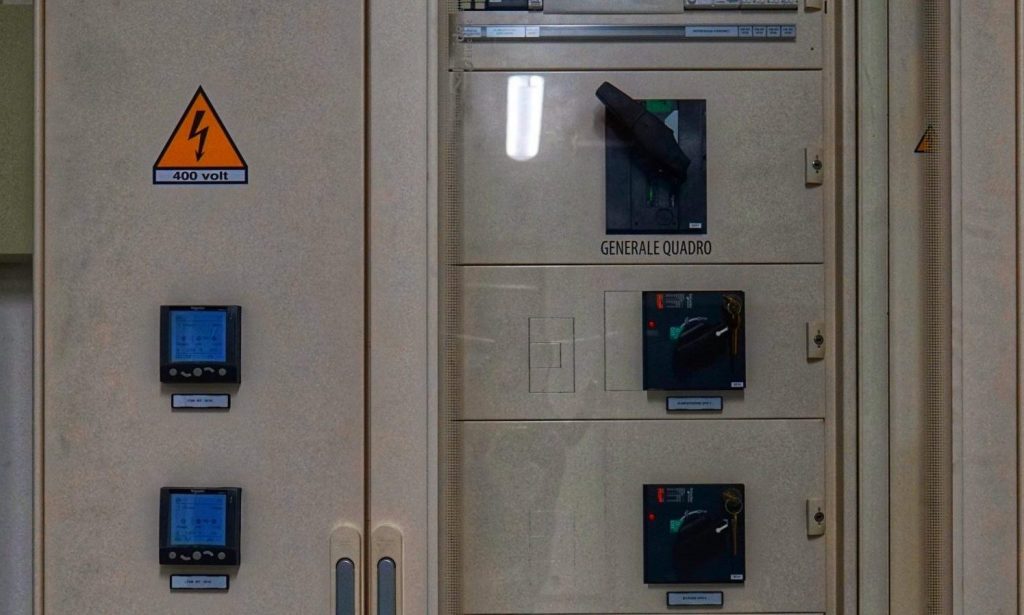

Sistema di Alimentazione e Raffreddamento

Il sistema di alimentazione consiste in due linee indipendenti (rete e gruppo elettrogeno) con doppio UPS.

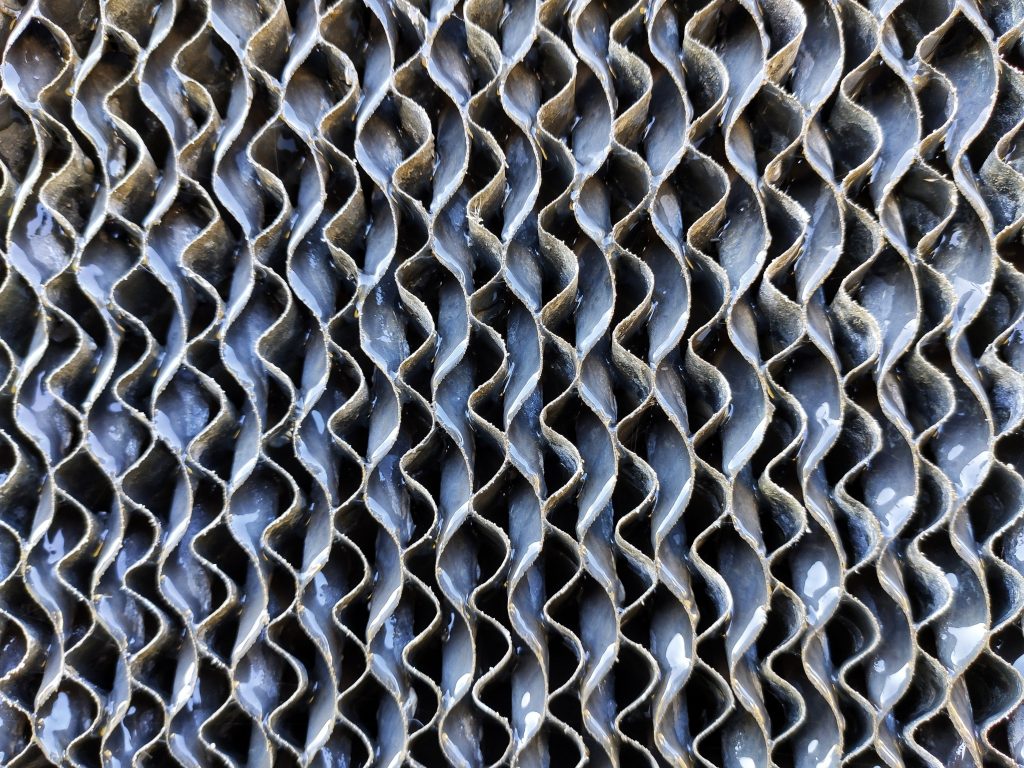

Il sistema di raffreddamento è basato free cooling e su chiller adiabatici che, avvalendosi dell’evaporazione dell’acqua per abbassare la temperatura dell’aria, consente di ottenere alti livelli di efficenza energetica.

L’accoppiamento di queste tecnologie consente di ottenere un basso PUE: nell’arco di 3 anni si è registrato un PUE di 1,2 (per ogni KW assorbito per il calcolo utile si sono resi necessari solo 200W aggiuntivi per il raffreddamento) quando molti data center hanno un PUE di 2 (per ogni KW utile al calcolo ne serve un altro per garantire il raffreddamento).

La rete

Il Data Center possiede una connettività interna ed esterna ad alta velocità ed elevata affidabilità.

È presente una connessione con topologia spine-leaf da 100Gb/s intra-datacenter e inter-datacenter. Le connessioni sono ridondate sia a livello fisico (fibre ottiche) sia ai livelli superiori (apparati di rete) per ottenere No Single Point of Failure.

La rete di interconnessione si basa sulla commutazione Ethernet di ultima generazione 25-400 Gb/s e Infiniband / Omnipath per i servizi HPC. Il DataCenter è collegato alla rete universitaria con una rete in fibra da 200 Gb/s e alla rete GARR con un collegamento da 100 Gb/s.

La possibilità di espansione

E’ in corso l’espansione del Data Center in una nuova sala adiacente. La nuova Sala metterà a disposizione 38 racks aggiuntivi. La filosofia dell’espansione, pur conservando i principi del disegno originale, implementerà soluzioni di raffreddamento Green di nuova generazione supportando sia sistemi raffreddati ad aria che sistemi ad alte prestazioni raffreddati a liquido in continuità con gli impianti già operativi. Saranno disponibili ulteriori 250KW di potenza elettrica.